Deep Learning

활성화 함수(Activation Function)의 종류

rubyda

2020. 10. 6. 21:32

728x90

활성화 함수(Activation Function) 개념

활성화 함수란 어떠한 신호를 입력받아을때 이를 적절한 처리를 하여 출력해주는 함수입니다. 이를 통해 출력된 신호가 다음 단계에서 활성화 되는지를 결정합니다.

활성화 함수(Activation Function) 종류

(1) 시그모이드 함수(sigmoid function)

(수식)

-

값이 작아질수록 0, 커질 수록 0에 수렴하는 구조이다.

-

출력이 0~1 사이로 즉 확률로 표현할 수 있다.

-

입력 값이 0에 가까울수록 출력이 빠르게 변한다.

-

* (binary- class classification)에 많이 사용이 된다.

(2) 하이퍼볼릭 탄젠트(tanh)

(수식)

-

값이 작아질수록 -1, 커질 수록 1에 수렴하는 구조이다.

-

입력 값이 0에 가까울수록 출력이 빠르게 변한다.

(3) 소프트맥스 함수(Sotfmax function)

(수식)

-

각 입력의 지수함수를 정규화한 것이다.

-

출력은 0~1 사이의 값을 가진다.

-

모든 출력의 합은 1이된다.

-

(softmax 함수는 Multi-class classification에 사용이 된다.)

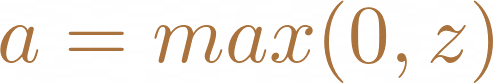

(4) ReLu function

(수식)

-

0보다 작은 값을 0으로 강제하는 함수이다.

-

미분 값이 일정(0 or 1)하기 때문에 학습이 잘 되는 특징이 있다.

-

매우 빠른 연산이 가능하다.

-

딥러닝에서 가장 많이 사용이 된다고 한다.